在当今的互联网时代,蜘蛛池作为一种网络优化手段逐渐受到关注。尤其是在 PHP 开发领域,利用 PHP 构建蜘蛛池具有一定的优势和挑战。本文将深入探讨如何使用 PHP 实现蜘蛛池,并分析其在网络优化中的作用。

PHP 作为一种广泛使用的服务器端脚本语言,具有简洁、高效、灵活等特点。这些特点使得 PHP 在开发各种 web 应用程序方面表现出色,包括蜘蛛池。蜘蛛池是指通过模拟搜索引擎蜘蛛的行为,将大量的网站链接提交给搜索引擎,以提高网站在搜索引擎中的排名。

在使用 PHP 构建蜘蛛池时,首先需要了解搜索引擎的工作原理和蜘蛛的行为模式。搜索引擎通过蜘蛛程序在互联网上爬行和抓取网页,建立索引并根据一定的算法对网页进行排名。蜘蛛通常会按照一定的规则和策略访问网站,例如遵循 robots.txt 文件的规定、避免重复抓取等。

为了模拟蜘蛛的行为,我们可以使用 PHP 的网络编程功能来发送 HTTP 请求并获取网页内容。通过编写 PHP 脚本,可以模拟蜘蛛的访问行为,例如设置请求头、处理重定向、处理 cookies 等。这样可以确保我们的蜘蛛池能够有效地访问目标网站,并获取到需要的信息。

在构建蜘蛛池的过程中,还需要考虑到网站的合法性和道德性。搜索引擎对于过度使用蜘蛛池等作弊行为是非常敏感的,一旦被发现,可能会导致网站被搜索引擎惩罚,甚至被删除。因此,在使用 PHP 构建蜘蛛池时,必须遵守搜索引擎的规则和网站的使用条款,不得进行任何违法或不道德的行为。

为了提高蜘蛛池的效率和效果,还可以采用一些优化策略。例如,可以使用多线程或异步编程来同时处理多个请求,提高抓取速度;可以使用缓存技术来减少重复请求和数据处理,提高性能;可以根据网站的重要性和相关性来调整抓取策略,提高抓取的质量。

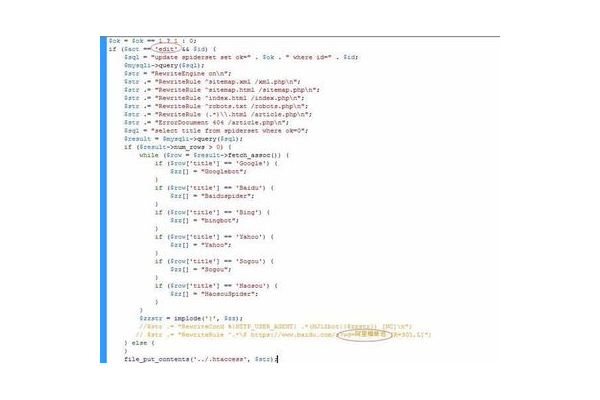

以下是一个简单的 PHP 代码示例,用于模拟蜘蛛的访问行为并获取网页内容:

```php

function spiderRequest($url) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

$response = curl_exec($ch);

curl_close($ch);

return $response;

}

$targetUrl = "https://www.example.com";

$htmlContent = spiderRequest($targetUrl);

if ($htmlContent) {

// 处理获取到的网页内容

echo "获取到网页内容:". $htmlContent;

} else {

echo "访问网页失败";

}

```

在上述代码中,`spiderRequest`函数用于发送 HTTP 请求并获取网页内容。通过设置 `CURLOPT_URL` 和 `CURLOPT_RETURNTRANSFER` 选项,我们可以指定要访问的 URL 和返回结果的格式。在主程序中,我们调用 `spiderRequest` 函数并传入目标网站的 URL,然后根据返回的结果进行相应的处理。

需要注意的是,以上代码只是一个简单的示例,实际的蜘蛛池构建可能需要更复杂的逻辑和功能。例如,需要处理错误处理、日志记录、并发控制等方面的问题。

使用 PHP 构建蜘蛛池是一种有效的网络优化手段,但需要遵守搜索引擎的规则和网站的使用条款,不得进行任何违法或不道德的行为。通过合理的设计和优化,可以提高蜘蛛池的效率和效果,为网站的排名提升做出贡献。也需要不断学习和探索新的技术和方法,以适应不断变化的搜索引擎环境和网络需求。

评论列表