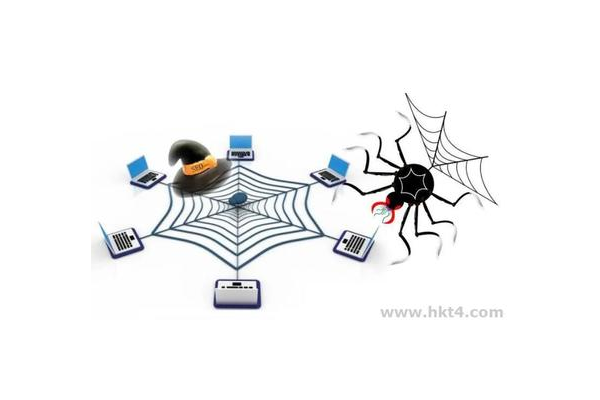

蜘蛛池爬取,是网络世界中一个备受关注的现象。在当今数字化信息飞速发展的时代,互联网上的海量内容如同浩瀚星辰,而蜘蛛池就像是穿梭其中的神秘猎手。它以独特的方式对网页进行爬取,试图探寻隐藏在其中的各种信息。蜘蛛池的存在,既有着其独特的运行机制和目的,也在网络生态中引发了诸多的讨论和影响。

蜘蛛池爬取的核心是利用大量的蜘蛛程序,这些蜘蛛就像勤劳的小工蚁,不断地在网络空间中穿梭。它们按照设定好的规则,对一个个网页进行访问和抓取。通过这种方式,蜘蛛池能够快速收集到丰富的网页数据,这些数据涵盖了各种各样的信息,包括文字、图片、链接等等。从某种程度上来说,蜘蛛池的爬取行为就像是为网络世界绘制一幅巨大的信息地图,将各个角落的内容都纳入其中。

蜘蛛池爬取的目的多种多样。对于一些网站运营者来说,他们希望通过蜘蛛池的爬取来提高自己网站的曝光度和流量。当蜘蛛频繁访问并抓取网站内容后,会将相关信息反馈给搜索引擎。这样一来,网站在搜索引擎结果页面中的排名就有可能得到提升,从而吸引更多的用户访问。这就如同在繁华的商业街道上,让自己的店铺更容易被路人看到一样,能够为网站带来更多的潜在客户和商业机会。

蜘蛛池爬取也并非总是一帆风顺,它也存在着一些问题和挑战。一方面,过度的爬取可能会给被访问的网站带来负担。大量的蜘蛛同时涌入网站,可能会导致网站服务器过载,出现访问缓慢甚至瘫痪的情况。这不仅会影响用户体验,也可能会对网站的正常运营造成损害。另一方面,一些不良的蜘蛛池可能会采用不正当的手段进行爬取,比如违反网站的robots协议,强行抓取一些不希望被公开的内容。这种行为不仅侵犯了网站所有者的权益,也破坏了网络信息的正常秩序。

为了应对蜘蛛池爬取带来的各种情况,网站管理者需要采取一系列的措施。合理设置网站的robots协议是至关重要的。通过明确规定哪些内容可以被爬取,哪些不可以,能够有效地引导蜘蛛的行为,保护网站的隐私和安全。网站管理者还需要关注服务器的负载情况,合理优化网站架构,提高网站的抗并发能力,以应对可能出现的大量蜘蛛访问。

对于整个网络生态而言,蜘蛛池爬取也有着深远的影响。它在一定程度上促进了信息的流通和共享,使得更多的优质内容能够被发现和传播。但也需要加强监管,规范蜘蛛池的行为,确保其在合法、合规的轨道上运行。只有这样,才能让蜘蛛池爬取在网络世界中发挥积极的作用,为用户提供更加丰富、有序的信息服务,而不是成为扰乱网络秩序的因素。

在未来,随着网络技术的不断发展,蜘蛛池爬取也可能会不断演变。新的算法和技术可能会被应用到蜘蛛的运行中,使其能够更加智能、高效地进行爬取工作。对于网络信息安全和隐私保护的要求也会越来越高,这将促使各方更加重视蜘蛛池爬取行为的规范和管理。我们需要在享受蜘蛛池爬取带来的便利的也要惕其可能带来的风险,共同营造一个健康、有序的网络环境。

蜘蛛池爬取是网络世界中一个复杂而又重要的现象。它既有着推动信息传播的积极作用,也存在着一些需要解决的问题。只有通过各方的共同努力,加强管理和规范,才能让蜘蛛池爬取更好地服务于网络发展,为我们带来更多有价值的信息和体验。

评论列表