爬虫,作为互联网世界中独特的探索者,以其自动化的数据采集能力,在信息的海洋里穿梭。它宛如一只无形的手,按照设定的规则和路径,精准地抓取着各种网页上的数据。从新闻资讯的更新、电商平台商品信息的收集,到学术资料的整合,爬虫在各个领域都发挥着重要作用。它能够高效地获取大量结构化或半结构化的数据,为数据分析、市场调研、内容推荐等众多业务提供了坚实的基础。

爬虫的活动并非总是一帆风顺。在网络环境中,不同网站对于爬虫的态度各异。有些网站欢迎爬虫的到访,认为它们有助于信息的传播和共享;而有些网站则对爬虫采取了严格的限制措施,甚至将其视为恶意行为。这是因为爬虫的过度访问可能会给网站带来一定的负担,影响其正常运行。部分爬虫的不规范操作可能导致数据的非法获取和滥用,侵犯网站所有者的权益。为了应对这些问题,网站开发者们设置了各种反爬虫机制,如验证码、IP 限制、访问频率控制等。

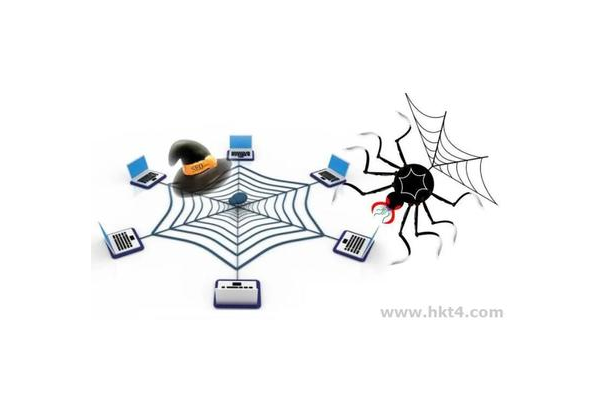

蜘蛛池则是在爬虫基础上发展起来的一种技术手段。它就像是一个精心构建的蜘蛛栖息地,通过集中管理大量的 IP 地址和服务器资源,为爬虫提供了更为高效和稳定的运行环境。在蜘蛛池中,多个爬虫可以并行工作,大大提高了数据采集的速度和效率。它能够模拟真实用户的访问行为,突破单个 IP 或服务器的限制,实现大规模的数据抓取。例如,在电商行业,利用蜘蛛池可以快速抓取竞争对手的商品价格、库存等信息,为企业的市场策略调整提供有力依据。

蜘蛛池的优势不仅体现在数据采集的速度上,还在于其对搜索引擎优化(SEO)的积极影响。搜索引擎依赖爬虫来索引网页内容,以便为用户提供准确的搜索结果。蜘蛛池能够帮助网站更快地被搜索引擎收录,提高网站在搜索结果中的排名。通过合理配置蜘蛛池中的爬虫策略,可以确保网站的内容被全面、及时地抓取,从而增加网站的曝光度和流量。对于内容创作者来说,这意味着他们的作品能够更快地被广大用户发现,提升作品的传播范围和影响力。

但是,蜘蛛池的使用也面临着一些挑战和风险。一方面,由于其涉及大量的 IP 地址和数据流量,容易引起网络服务提供商的关注和监管。如果使用不当,可能会违反网络服务协议,导致账号被封禁或面临法律风险。另一方面,一些不良分子可能会利用蜘蛛池进行恶意的网络攻击或非法数据采集活动,损害其他网站的利益和网络安全环境。因此,在使用蜘蛛池时,必须严格遵守法律法规和道德规范,确保其合法、合规、安全地运行。

在当今数字化快速发展的时代,爬虫和蜘蛛池作为数据采集和网络优化的重要工具,有着广阔的应用前景。但我们必须正确认识它们的作用和风险,在合法合规的前提下,充分发挥它们的优势,为互联网的健康发展和信息的有效利用贡献力量。只有这样,我们才能在数据驱动的时代浪潮中,实现技术与道德、法律的和谐共生,推动互联网行业持续稳健地向前发展。随着技术的不断进步,我们也期待着更加智能、安全、高效的爬虫和蜘蛛池技术的出现,为互联网世界带来更多的便利和创新。

评论列表