在当今互联网信息爆炸的时代,数据的获取与利用变得至关重要。对于从事网络信息收集、数据分析等工作的人来说,掌握高效的数据抓取技术是必不可少的技能。而学习蜘蛛池抓取,正是提升数据获取能力的一条重要途径。蜘蛛池抓取并非是一个简单的概念,它涉及到网络爬虫技术、服务器搭建、数据处理等多个方面的知识。通过学习蜘蛛池抓取,我们能够更精准、更快速地获取所需的网络数据,为后续的分析和应用提供有力支持。

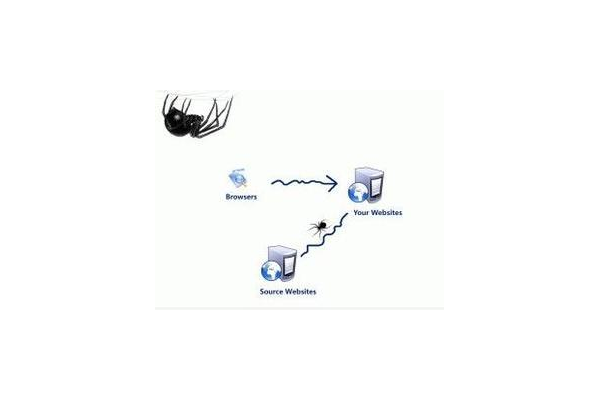

要理解蜘蛛池抓取,就必须先了解网络爬虫的基本原理。网络爬虫就像是互联网上的“蜘蛛”,按照一定的规则,自动地抓取网页信息。它通过向目标网站发送请求,获取网页的HTML代码,然后从中提取出我们需要的数据。在实际操作中,单一的爬虫往往会受到各种限制,比如网站的反爬虫机制、IP封禁等。这时候,蜘蛛池就发挥了重要作用。蜘蛛池是由大量的IP地址组成的集合,通过使用蜘蛛池,可以实现IP的轮换,避免因频繁请求而被网站封禁,从而保证数据抓取的连续性和稳定性。

学习蜘蛛池抓取,需要掌握相关的编程语言和工具。Python是目前最流行的用于网络爬虫开发的编程语言之一,它具有丰富的库和框架,如Requests、BeautifulSoup、Scrapy等。Requests库可以方便地发送HTTP请求,获取网页内容;BeautifulSoup库则可以对HTML和XML文档进行解析,提取出我们需要的数据;Scrapy是一个强大的爬虫框架,它提供了高效的爬取机制和数据处理功能。通过学习这些工具的使用,我们可以更加高效地开发出自己的爬虫程序。

在搭建蜘蛛池时,需要考虑多个方面的因素。首先是IP资源的获取,我们可以通过购买代理IP、使用免费代理IP或者搭建自己的代理服务器来获取大量的IP地址。购买代理IP可以获得稳定的服务,但成本相对较高;免费代理IP虽然成本低,但稳定性和可用性较差;搭建自己的代理服务器则需要一定的技术和资源,但可以实现更高的定制化和可控性。其次是IP的管理和维护,我们需要建立一个IP池管理系统,对IP地址进行实时监控和更新,确保IP的可用性和稳定性。

除了技术层面的学习,还需要了解相关的法律法规和道德规范。在进行数据抓取时,必须遵守网站的使用条款和相关法律法规,不得进行非法的数据采集和滥用。也要尊重网站的隐私和权益,避免对网站造成不必要的负担和影响。

学习蜘蛛池抓取还需要不断地实践和总结。通过实际项目的练习,我们可以更好地掌握蜘蛛池抓取的技术和方法,同时也可以发现和解决实际问题。在实践过程中,要注意积累经验,不断优化自己的爬虫程序,提高数据抓取的效率和质量。

学习蜘蛛池抓取是一个综合性的过程,它涉及到技术、管理、法律等多个方面的知识。通过系统的学习和实践,我们可以掌握这一技术,为自己在网络信息领域的发展打下坚实的基础。在未来的互联网发展中,数据将成为最重要的资产之一,掌握蜘蛛池抓取技术,将有助于我们更好地获取和利用数据,为自己的职业发展和个人成长带来更多的机会。让我们积极投入到学习蜘蛛池抓取的过程中,不断提升自己的能力,迎接未来的挑战。

评论列表